Farmacología

Cómo leer un artículo sobre inteligencia artificial (IA)

07 julio 2025

Este artículo guía al lector a través de la evaluación crítica de un artículo que aborda el uso de la inteligencia artificial (IA) en entornos clínicos para la atención médica. Se ofrece una breve introducción a los diferentes tipos de IA utilizados en la atención médica, junto con algunos principios éticos para guiar la introducción de sistemas de IA en la atención médica. Se destacan las directrices de publicación existentes para estudios de IA. Se sugieren diez preguntas preliminares sobre un artículo que describe un algoritmo de apoyo a la toma de decisiones basado en IA. BMJ Medicine, abril 2025

La contribución de la inteligencia artificial a la búsqueda de literatura biomédica: ¿revolucionando o complicando?

09 junio 2025

Nuestros resultados demostraron que las funciones básicas de ChatGPT tenían limitaciones en consistencia, precisión y relevancia. Las herramientas de soporte al usuario mostraron mejoras, pero las limitaciones persistieron. Curiosamente, cada escenario de búsqueda bibliográfica planteó diferentes desafíos: abundancia de fuentes de información secundaria sobre temas de gran interés y literatura poco convincente sobre temas nuevos o especializados. Este estudio analizó ejemplos prácticos que destacan tanto el potencial como las dificultades de integrar la IA conversacional en los procesos de búsqueda bibliográfica y subrayan la necesidad de realizar evaluaciones comparativas rigurosas de las herramientas de IA en la investigación científica. PLOS Digital Health, 12 de mayo de 2025

Las personas confían demasiado en los consejos médicos generados por IA a pesar de su baja precisión

26 mayo 2025

La mayor confianza depositada en el consejo médico inexacto o inapropiado generado por IA puede conducir a diagnósticos erróneos y consecuencias perjudiciales para las personas que buscan ayuda. Los sistemas de IA deberían implementarse en colaboración con los profesionales médicos cuando se utilicen para la prestación de consejo médico, a fin de evitar la desinformación y aprovechar al máximo los beneficios de esta tecnología de vanguardia. New England Journal of Medicine AI, 13 de mayo de 2025.

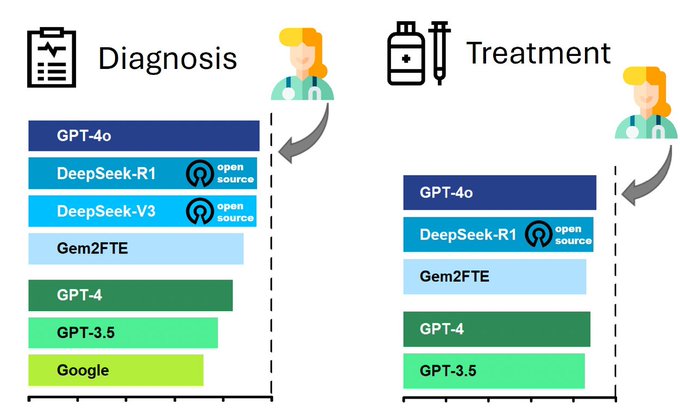

Evaluación de referencia de los modelos de lenguaje grande de DeepSeek en la toma de decisiones clínicas

28 abril 2025

Nuestro estudio demuestra que los modelos de lenguaje amplio (LLM) de código abierto pueden proporcionar una vía escalable para el entrenamiento seguro de modelos, lo que permite aplicaciones médicas reales que cumplen con las normativas de privacidad de datos y atención sanitaria. Nature Medicine, 23 de abril de 2025

Inteligencia artificial en salud pública: promesas, desafíos y una agenda para los responsables políticos y las instituciones de salud pública

10 abril 2025